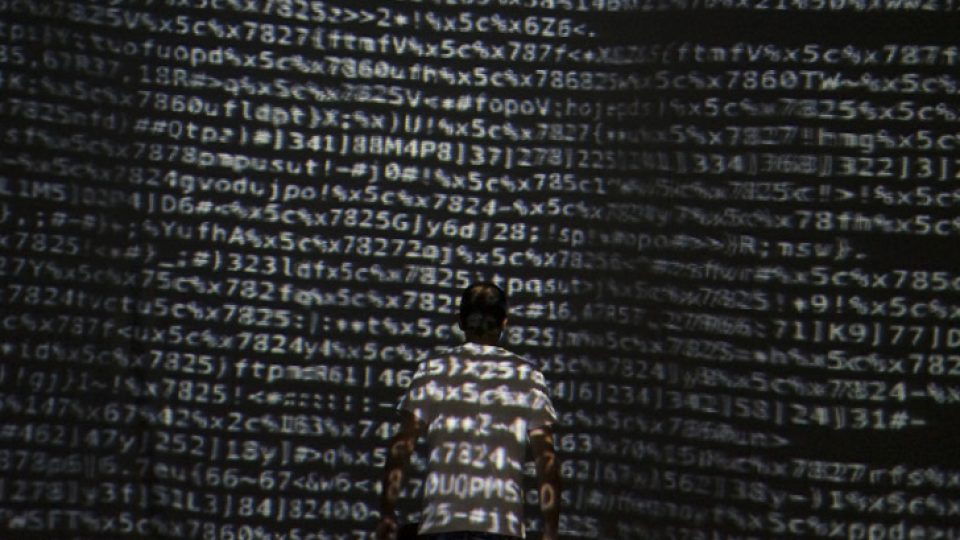

Quel magazine de presse spécialisée n’a pas fait sa une au cours des 12 derniers mois sur le big data ? Si l’on suit le schéma d’analyse du hype cycle de Gartner, nous sortons probablement d’une belle séquence de sur-promesses. Et cela tient essentiellement à trois raisons.

La plus évidente est que l’implémentation de solutions réellement performantes demande un niveau de technicité et d’investissement dans les infrastructures qui n’est accessible encore aujourd’hui qu’à un petit nombre d’organisations. Mettre en place un système de prédiction du churn (terme anglais qui désigne la perte de clientèle ou d’abonnés) sur la base de l’analyse systématique de toutes les données remontées par tous les touchpoints client (application mobile, site web, call center, magasin, e-mailing, réseaux sociaux…) exige en prérequis : l’existence de dispositifs de collecte, puis une couche d’agrégation des données, puis une couche de consolidation et de traitement, enfin des modes de restitution dans les systèmes d’information ou auprès des collaborateurs (vendeurs, service client). La chaîne complète peut prendre plusieurs années et de nombreux investissements en compétences et en infrastructures avant de porter ses fruits.

Réapprendre à lire

La seconde est liée à l’ambiguïté de la promesse. Si l’un des aspects du big data est de pouvoir « faire émerger » de la donnée, des enseignements qu’on ne pourrait pas forcément anticiper, cela ne doit pas affranchir les décideurs d’une problématisation en amont de ce type de démarche. On ne sait pas forcément ce qu’on cherche, mais il est nécessaire pour être efficace d’avoir identifié une problématique métier que l’on cherche à résoudre : limiter le churn, améliorer la productivité, détecter de nouvelles tendances pour stimuler l’innovation produit. Sans cela, on risque de se perdre dans une analyse de données sans but, qui rend difficile la mobilisation et l’ownership par des équipes en interne. C’est notamment cette vision plus applicative de la donnée qui constitue l’un des fondements de la notion d’intelligence étendue.

La dernière est la conséquence du fait qu’en réalité, peu de situations dans les organisations nécessitent réellement du « big ». Aujourd’hui, la plupart des datasets véritablement éligibles à la détection d’opportunités pour les brainworkers sont très loin des volumes qui caractérisent le big data. Entendons-nous bien, il est toujours possible de mettre des gros volumes de données en face d’une problématique, mais après les étapes de qualification, nettoyage, et ciblage, on en vient bien souvent à des quantités très raisonnables : quelques dizaines de milliers de verbatim, quelques centaines de milliers de données de connexion, rien qui justifie la mobilisation de technologies avancées de bases de données.

Focalisons nous sur les usages, et laissons au big data le temps de mûrir pour atteindre les dernières étapes de son cycle, ce qui devrait prendre encore quelques années…