CLIQUER SUR PLAY POUR ECOUTER LA VERSION AUDIO :

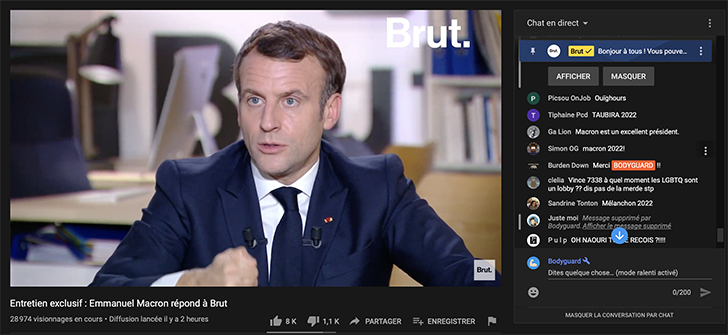

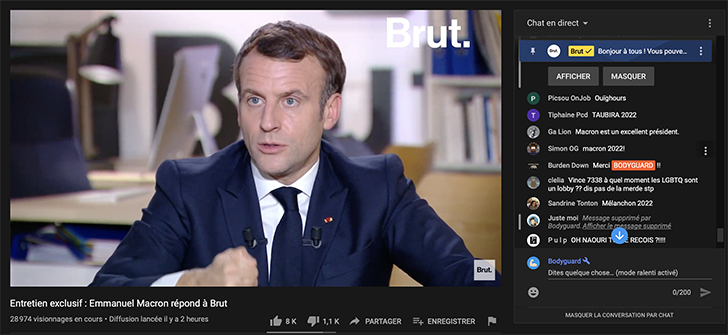

La modération sur les médias sociaux est un sujet de fond, essentiel pour la qualité de l’environnement de discussion et pour éviter les propos haineux. Il devient parfois une condition absolue, comme l’a expérimenté Brut lors de l’interview du président de la République Emmanuel Macron, le 4 décembre 2020. A l’occasion de cette étape importante de sa jeune vie, le média social travaillé avec Bodyguard, start-up niçoise avec laquelle il a été mis en relation par le biais de France Digitale, car sa technologie détecte les contenus nocifs ou la haine en ligne. « Nos équipes de social management ont beaucoup travaillé avec Bodyguard pour calibrer la modération et nous assurer que, dans un format d’interview différent de d’habitude et surtout appuyé sur la réalité des conversations sociales, le président, la communauté Brut et les gens qui suivaient l’interview puissent vivre une expérience intéressante », souligne Guillaume Lacroix, fondateur et CEO de Brut.

Près de 100 000 commentaires analysés

Durant les 2h25 de l’interview, 95 864 commentaires ont ainsi été modérés. Si 96 % d’entre eux étaient neutres, 2 % étaient toxiques (avec une grande partie d’insultes) et 2 % positifs. Une taskforce entre Brut, Bodyguard et les responsables français des plateformes qui ont hébergé le direct – Facebook, YouTube et Twitch – a été montée pour l’occasion. « Au-delà de l’importance de la modération pour ces plateformes, notamment Facebook, avoir pour la première fois une interview du président de la République, à un moment aussi important de son quinquennat, nous exposait à un risque d’attaque coordonnée. Elle n’a heureusement pas eu lieu, mais nous devions l’anticiper », poursuit-il. La fin justifiait les moyens…

Une modération plus permissive que sur les médias traditionnels

Deux jours avant l’interview, Bodyguard a envoyé un lien à Brut pour permettre au média social de connecter ses pages Facebook, YouTube et Twitch et de bénéficier de la technologie d’analyse sémantique. Si la start-up n’avait pas de doute sur sa technologie, qui protège depuis plus de trois ans des individus, des familles et désormais des entreprises, elle s’interrogeait sur le type de modération à mettre en place. « Dans les jours qui ont suivi la connexion, nous avons travaillé sur la personnalisation du service et opté avec Brut pour une modération un peu ‘permissive’, qui appuie sa domination sur le marché des nouveaux médias. C’était d’autant plus intéressant que cela contraste avec la modération ultra stricte des médias traditionnels, qui ne prennent aucun risque juridique sur les contenus hébergés sur leurs sites internet et où le moindre mot un peu insultant est supprimé », observe Charles Cohen, fondateur et pdg de Bodyguard. Tout aussi responsable que ses aînés sur les contenus postés sur ses supports, Brut s’autorise toutefois une approche un peu différente. « Tout ce qui tombe sous le coup de la loi n’a évidemment rien à faire chez nous et cela ne fait l’objet d’aucun débat. Mais les générations qui nous suivent ont l’habitude de tenir certains propos sans que ce soit forcément perçu comme blessant, insultant ou dur, précise Guillaume Lacroix. Elles doivent pouvoir le faire aussi sur les réseaux sociaux. Nous voulons donc éviter les bulles de filtre et permettre aux gens de s’exprimer de manière parfois véhémente, dans un cadre qui reste admissible. »

L’importance du contexte

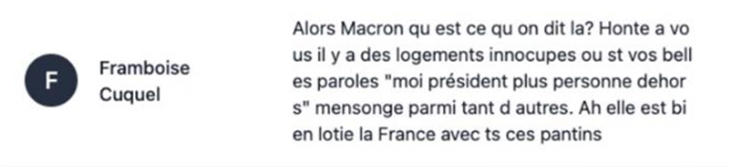

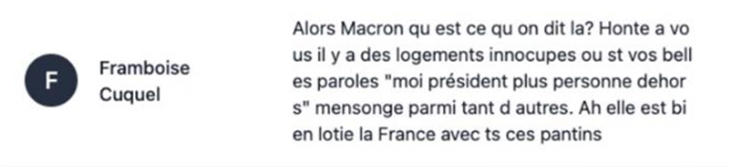

Dans la manière dont les deux partenaires ont placé le curseur, des commentaires du type « Gouvernement de merde » pouvaient donc passer. Egalement jugé non-insultant dans le débat : « Ah, elle est bien lotie la France avec ts ces pantins »… Tout reste pourtant une question de contexte. Les études de social data réalisées à la suite des événements publiés sur Brut ont mis en lumière les émotions particulières générées par les interviews live. « Une modération hard core qui ne prendrait pas en compte l’émotion derrière la violence du vocabulaire, donc une modération trop dure, ne permettrait pas aux gens de pouvoir s’exprimer ou de partager leur mécontentement, justifie Guillaume Lacroix. Nous avons aussi la chance de pouvoir nous appuyer sur une communauté qui s’autorégule beaucoup. Il y a de fortes chances que, face à un propos comme ‘Gouvernement de merde’, des membres réagissent d’eux-mêmes pour dire ‘T’es pas obligé de dire ça’ ou ‘T’as pas autre chose à dire’… Cela explique aussi pourquoi, dans ce contexte précis et parce que la technologie de Bodyguard détecte les spécificités du langage propre aux réseaux sociaux, on s’est dit que l’on pouvait ouvrir un tout petit peu la modération». Quand le niveau d’émotion redescend, les règles sont réadaptées. De manière permanente, le média social supprime systématiquement tous les commentaires qui attaquent ses journalistes. « C’est rare, mais il faut faire très attention », reconnaît-il.

A chaque plateforme, un traitement adapté

Lors de l’interview d’Emmanuel Macron, un traitement particulier a été appliqué à chaque plateforme pour tenir compte des usages des utilisateurs. Le taux de toxicité a atteint 2,3 % des commentaires sur Facebook, 1,6 % sur YouTube et 1,2 % sur Twitch. Les taux de positivité étaient assez similaires, à 1,7 % ou 1,8 %. « Les contenus retirés sur Facebook étaient majoritairement des insultes assez violentes et sévères. Sur YouTube et Twitch, il s’agissait davantage de haine du style ‘Dégage’ ou ‘Casse-toi’. Cela s’explique en partie par les filtres que YouTube met déjà sur les insultes », explique Charles Cohen. Ce traitement au cas par cas est, selon lui, un moyen d’avoir une approche plus fine de la modération et même de changer la vision autour de la question. « Ceux qui ont été censurés sur Twitter ont migré sur Parler (suspendu depuis le 11 janvier 2021, ndlr), qui n’était absolument pas modéré. A trop modérer, on ne résout pas le problème, on le déplace », affirme-t-il. La modération étant aussi une question d’éducation, elle devrait même se faire, selon lui, au niveau de l’utilisateur : « Chacun doit pouvoir choisir le type de contenu auxquels il souhaite avoir accès ». Dans la technologie Bodyguard, une fonctionnalité permet de faire évoluer les règles de l’analyse sémantique. Le degré de vigilance est par exemple renforcé sur les sujets de transsexualité et de body shaming.